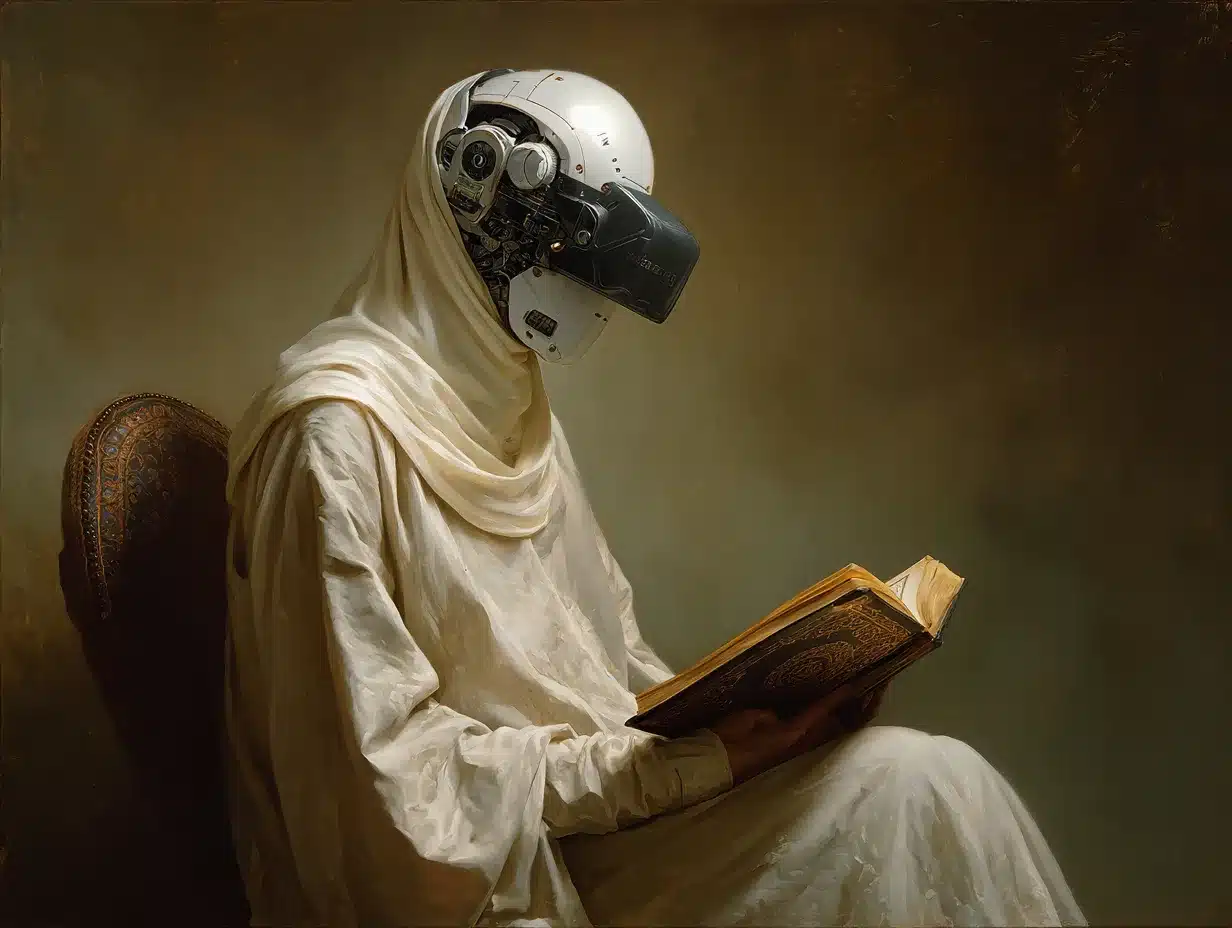

وقتی از هوش مصنوعی حرف میزنیم، معمولاً یاد یک ماشین دقیق و بیطرف میافتیم که فقط حساب میکند و نتیجه میدهد. اما در واقع، هوش مصنوعی بیشتر شبیه یک «مفسر» است تا یک ماشین.

هر پاسخی که یک چتبات یا هوش مصنوعی به ما میدهد، نوعی تفسیر از دادههایی است که از انسانها یاد گرفته.

مدلهای زبانی یا همان هوش مصنوعی، با میلیاردها جمله انسانی آموزش میبینند. از کتابها، سایتها، گفتوگوهای آنلاین و نوشتههای مردم در زمانها و فرهنگهای مختلف. اما این دادهها را کسی باید ابتدا انتخاب کند. توسعهدهندگان هوش مصنوعی تصمیم میگیرند چه منابع و دادههایی برای آموزش به هوش مصنوعی استفاده شوند و چه منابعی حذف شوند. همین تصمیمها، هرچند فنی به نظر میرسند، باعث میشوند هر مدل هوش مصنوعی، دیدگاهی خاص از جهان پیدا کند.

برای مثال، اگر بیشتر دادهها از جوامع غربی باشند، مدل هم جهان را با زاویه نگاه غربی میبیند. البته نه از روی عمد، بلکه چون منابعش از همانجاست. به این ترتیب، وقتی ما با هوش مصنوعی حرف میزنیم، در واقع با مجموعهای از تفسیرهای انسانی روبهرو هستیم.

شباهت میان تفسیر دینی و تفسیر الگوریتمی

در گذشته، مفسران قرآن و انجیل با یک پرسش اساسی روبهرو بودند:

چطور میشود سخن خدا را درست فهمید، وقتی هر انسان در زمان و فرهنگی خاص زندگی میکند؟

کسی که هزار سال پیش آیهای را تفسیر میکرد، دنیایش با مفسری که امروز زندگی میکند فرق داشت. شرایط اجتماعی، زبان، و حتی تصویر او از خدا متفاوت بود. برای همین، معنا هرگز ثابت نمیماند و تفسیر با زمان تغییر میکرد.

امروز، همین اتفاق در دنیای فناوری هم رخ میدهد. فیلسوف ایتالیایی آلبرتو رومله (Alberto Romele) میگوید نرمافزار هم مثل مفسر است، چون معنا را هم میسازد و هم تفسیر میکند.

برای اینکه این حرف روشنتر شود، تصور کنید برنامهنویسی میخواهد کاری کند که هوش مصنوعی بفهمد وقتی کاربر میگوید «من سردمه»، باید دمای اتاق را بالا ببرد. او باید نیت انسانی را به زبان کامپیوتر ترجمه کند و در قالب یک دستور ساده بنویسد که مثلاً اگر کاربر گفت «سردمه»، دما را چند درجه زیاد کن. در همین لحظه، او میان زبان انسان و زبان ماشین پل میزند.

اما ماجرا اینجا تمام نمیشود. وقتی سیستم پاسخ میدهد و میگوید «دمای محیط بالا رفت»، خودش هم در حال تفسیر همان دستور است. در هر دو مرحله، هم در نوشتن دستور، هم در پاسخ دادن، احتمال تغییر معنا وجود دارد. شاید کاربر از سر خستگی گفته باشد «سردمه»، نه بهخاطر دما. یا شاید سیستم بیش از حد واکنش نشان دهد و هوا را بیش از اندازه گرم کند.

این همان چیزی است که در تفسیر متون دینی هم اتفاق میافتد: هیچ ترجمه یا تفسیری، حس و نیت اصلی را دقیق منتقل نمیکند. به همین معنا، هر الگوریتم هم نوعی مفسر است.

الگوریتمهای نژادپرست

در دنیای فناوری، زیاد شنیده میشود که میگویند هوش مصنوعی دچار سوگیری (Bias) شده است. منظور از سوگیری این است که سیستم در تصمیمگیری یا نتیجهگیری، بیطرف عمل نکرده و به یک سمت خاص تمایل نشان داده است.

اما اگر از زاویه تفسیر نگاه کنیم، سوگیری فقط یک خطای فنی نیست. در واقع، نوعی برداشت محدود از جهان است. هوش مصنوعی جهان را همانطور بازنمایی میکند که در دادههایش دیده، نه آنطور که در واقعیت وجود دارد. اگر دادهها ناقص یا یکطرفه باشند، تصویری که مدل میسازد هم ناقص خواهد بود.

پژوهشگر آمریکایی صفیه اوموجا نوبل (Safiya Umoja Noble) در کتاب خود Algorithms of Oppression نشان میدهدکه در سالهای اولیه شرکت گوگل، وقتی کسی عبارت «black girls» را جستوجو میکرد، نتایجی توهینآمیز و کلیشهای نمایش داده میشد، در حالی که برای «white girls» نتایج خنثی و معمول بود. گرچه هیچ برنامهنویسی عمداً قصد بیاحترامی نداشت و الگوریتم هم بهخودیخود نژادپرست نبود. اما مشکل از دادهها میآمد، دادههایی که از دنیایی پر از تبعیض و نابرابری گرفته شده بودند.

در نتیجه، الگوریتم فقط همان نابرابریهای موجود را تکرار کرد. در واقع، سوگیری (Bias) در اینجا به معنای دشمنی یا قصد بد نیست، بلکه یعنی الگوریتم جهان را از زاویهای بسیار محدود دیده است.

همین اتفاق در جاهای دیگر هم تکرار شد. مثلاً وقتی شرکتها از دادههای تاریخی استخدام خود برای آموزش سیستمهای انتخاب نیرو استفاده کردند، مدلها بهطور ناخودآگاه زنان را نادیده گرفتند، چون در دادههای قدیمی بیشتر کارکنان مرد بودند. در سیستمهای تشخیص چهره نیز، چون بیشتر تصاویر آموزشی از افراد سفیدپوست بود، مدل چهرههای تیرهتر را کمتر و با دقت پایینتر تشخیص میداد.

به زبان ساده، الگوریتم سوگیری را اختراع نکرد، فقط آن را تکرار و خودکار کرد.

سوگیری نشان بیعدالتی است؟

بعد از آن که موارد متعددی از سوگیری (Bias) در سیستمهای هوش مصنوعی آشکار شد، بسیاری از شرکتهای فناوری و دانشگاهها تصمیم گرفتند دستبهکار شوند. پروژههایی با عنوانهایی مثل «هوش مصنوعی مسئولانه» (Responsible AI) یا «اخلاق در الگوریتم» شکل گرفتند.

مهندسان و پژوهشگران دوباره به سراغ دادههایشان رفتند و دادههایی که قبلا برای آموش هوش مصنوعی حذف شده بودند را برگرداندند و سعی کردند تعادل بهتری میان گروههای مختلف دادهها برقرار کنند. هدف این بود که اگر بفهمیم سوگیری از کجا آغاز میشود، بتوانیم جلوی تکرارش را بگیریم. در ظاهر، این یک کار فنی است، اما در عمق خود یک مسئله اخلاقی و فرهنگی است. چون تصمیم درباره اینکه «عدالت» یعنی چه، خودش نوعی تفسیر است.

اما اینجا یک پرسش اساسی مطرح میشود: وقتی میگوییم الگوریتمها دچار سوگیری (Bias) هستند، آیا منظورمان این است که هر تفاوتی میان گروهها نتیجه بیعدالتی است؟ یا گاهی این تفاوتها ریشه در واقعیتهایی دارند که ربطی به تبعیض ندارند، مثل تاریخ، جغرافیا یا امکانات طبیعی؟

برای مثال، فرض کنید یک مدل هوش مصنوعی قرار است درباره حملونقل عمومی در کشورهای مختلف یاد بگیرد. اگر بیشتر دادههای آن از ژاپن باشد، مدل احتمالاً به این نتیجه میرسد که «اتوبوس همیشه سر وقت میرسد». اما وقتی همین مدل در کشوری بهکار گرفته میشود که قطارها همیشه دیر میرسند، پیشبینیهایش اشتباه از آب درمیآیند، نه چون تبعیضآمیز است، بلکه چون جهان را فقط از زاویه کشورهای منظمتر دیده است.

در واقع، گاهی آنچه ما «سوگیری» مینامیم، حاصل تفاوت در تجربهها و زمینههاست، نه بدخواهی یا بیعدالتی.

غلبه دادههای غربی

اقتصاددان و اندیشمند آمریکایی توماس سووِل (Thomas Sowell) در کتابهای خود Conquests and Cultures (۱۹۹۸) و Wealth, Poverty and Politics (۲۰۱۵) توضیح میدهد که مسیر تمدنها همیشه از عدالت یا ظلم تعیین نشده، بلکه از جغرافیا، منابع و شرایط طبیعی تأثیر گرفته است.

بهگفتهی سووِل، تمدنهایی که در مناطق کوهستانی یا خشک قرار داشتند، کمتر فرصت تجارت و ارتباط داشتند، در حالی که جوامع کنار رودخانهها یا مناطق معتدل زودتر به سواد و صنعت دست یافتند. این یعنی بخش زیادی از تفاوتهای فرهنگی یا اقتصادی، نتیجه تصمیمهای اخلاقی نیست، بلکه محصول محیط و شرایط تاریخی است.

اگر این دیدگاه را به دنیای هوش مصنوعی تعمیم دهیم، میتوان گفت دادههایی که امروز مدلهای زبانی با آنها آموزش میبینند، بیشتر از غرب آمدهاند، اما نه بهخاطر تبعیض عمدی، بلکه چون غرب زودتر صنعتی شد و در تکنولوژی پیشرفت کرد و در نتیجه دادههای بیشتری از خودش بهجا گذاشت.

در نتیجه، غلبه دادههای غربی در فضای دیجیتال، اگرچه نگاه مدلها را یکسویه میکند، اما ریشهی آن لزوماً اخلاقی یا سیاسی نیست، بلکه تاریخی است.

در اینجا مسئله ظریفی شکل میگیرد. اگر بپذیریم که دادههای جهان نابرابرند، چطور باید آن را اصلاح کرد بدون اینکه تاریخ را دستکاری کنیم؟ آیا باید دادههای موجود را تغییر دهیم تا «عادلانهتر» شوند، یا باید دادههای تازه از فرهنگها و زبانهای دیگر تولید کنیم تا تصویر کاملتری از جهان بسازیم؟

راهحل شاید در پذیرفتن واقعیت تفاوتها است، نه در انکار آنها. پذیرفتن اینکه هر جامعهای مسیر تاریخی خودش را داشته، به ما کمک میکند بدون تخریب دادههای قدیمی، دانش جدید و متنوعتری بسازیم.

عدالت در هوش مصنوعی فقط به معنای «برابری نتایج» نیست، بلکه به معنای درک ریشههای تفاوتها است. اگر تفسیر هر جامعه از حقیقت با دیگری فرق دارد، هوش مصنوعی هم باید بازتابدهنده این گوناگونی باشد، نه ابزاری برای یکسانسازی نگاهها.

هرمنوتیک، پلی میان ایمان و الگوریتم

اگر از آغاز این مسیر نگاه کنیم، از تفسیر آیات تا تفسیر دادهها، یک چیز همیشه تکرار میشود: هیچ فهمی خنثی نیست.

در زمانهای قدیم، برخی از مفسران قرآن و انجیل میدانستند که هر خوانش، رنگ زمان و زبان خود را دارد. امروز، توسعهدهندگان هوش مصنوعی در موقعیتی مشابه ایستادهاند. آنها هم با متون و دادهها سروکار دارند و هر تصمیمشان درباره اینکه چه چیزی را به هوش مصنوعی نشان دهند و یا چه چیزی را حذف کنند، در واقع نوعی تفسیر از جهان است.

اینجاست که مفهوم هرمنوتیک (Hermeneutik) دوباره معنا پیدا میکند.

هرمنوتیک در اصل، نظریه تفسیر است: دانشی که میکوشد توضیح دهد چگونه انسان معنا را از متن میگیرد و چطور خودش آن معنا را بازمیسازد. اما امروز، هرمنوتیک فقط به دین و فلسفه تعلق ندارد، به فناوری هم رسیده است.

هوش مصنوعی، همانقدر که محصول منطق است، محصول تفسیر است. هر پاسخ آن، نتیجه انتخابها، محدودیتها و ترجمههاییست که انسانها درونش نوشتهاند.

در این نگاه، الگوریتمها مانند مفسران هستند. همانطور که مفسر دینی آیهای را میخواند و در دل زبان و فرهنگش معنا میکند، هوش مصنوعی هم دادههای جهان را میخواند و بازتاب میدهد. و همانطور که هیچ تفسیر دینی نهایی نیست، هیچ مدل زبانی هم بینقص یا بیطرف نیست.

این ایدهی بازتاب و تفسیر در فناوری، یادآور دیدگاهی است دربارهی حلقه ی آینه ای، جایی که ذهن در فرایند بازتاب خود معنا را میسازد.

اما این وضعیت لزوماً تهدید نیست. درست فهمیدهشدن هرمنوتیک یعنی دانستن همین نکته: بیطرفیِ مطلق ممکن نیست، اما آگاهی از پیشداوریها میتواند ما را منصفتر کند.

در الاهیات، در حالت ایدهآل، مفسر کسی است که میداند ممکن است برداشتش اشتباه باشد و برای همین با دیگران گفتوگو میکند. در دنیای فناوری هم، توسعهدهنده کسی است که میداند الگوریتمش کامل نیست و میکوشد آن را در گفتوگو با نگاههای دیگر اصلاح کند.

پس در نهایت، چه درباره کتابی مقدس حرف بزنیم و چه درباره یک مدل هوش مصنوعی، مسئله یکی است:

معنا، در گفتوگو شکل میگیرد، میان انسان و متن، میان انسان و انسان، و در نهایت میان انسان و ماشین.

همانطور که آیات الهی بدون مفسر زنده نمیمانند، دادهها هم بدون درک انسانی معنا پیدا نمیکنند.

مطلب جالبی بود و به نکته خوبی اشاره شد.

موافقم، بی طرفی مطلق ممکن نیست.

حتی اگر داده های جهان را کامل در اختیار یک ابر هوش مصنوعی بگذارند، باز هم خروجی بی طرفانه نخواهد بود، همچنان که گفتید.

آموزنده بود و پسندیدم